Die „Neue Energiewirtschaft“: Eine Übung in magischem Denken

Mark P. Mills, 26.3.2019, Manhattan Institute.org

aus dem Englischen von Martin Christen

EXECUTIVE SUMMARY

Seit Jahrzehnten wächst eine Bewegung, die Kohlenwasserstoffe ersetzen will, die zusammen 84% der weltweiten Energie liefern. Es begann mit der Angst, dass uns das Öl ausgeht. Diese Angst ist inzwischen in den Glauben übergegangen, dass die Gesellschaft aufgrund des Klimawandels und anderer Umweltbelange die Verbrennung von Öl, Erdgas und Kohle nicht mehr tolerieren kann – die sich alle als reichlich vorhanden erwiesen haben.

Bisher liefern Wind, Sonne und Batterien – die bevorzugten Alternativen zu Kohlenwasserstoffen – etwa 2% der weltweiten Energie und 3% der Energie der USA. Dennoch hat ein kühner neuer Anspruch an Popularität gewonnen: dass wir an der Schwelle zu einer technologiegetriebenen Energierevolution stehen, die nicht nur alle Kohlenwasserstoffe schnell ersetzen kann, sondern zwangsläufig auch wird.

Diese „neue Energiewirtschaft“ beruht auf der Überzeugung – ein Kernstück des Green New Deal und anderer ähnlicher Vorschläge sowohl hier als auch in Europa – dass die Technologien der Wind- und Solarenergie sowie der Batteriespeicherung einen ähnlichen Durchbruch erfahren wie Computer und Telekommunikation, dass die Kosten drastisch gesenkt und die Effizienz gesteigert wird. Aber diese Kernanalogie überstrahlt tiefgreifende, physikalisch begründete Unterschiede zwischen Systemen, die Energie produzieren und solchen, die Informationen verarbeiten.

In der Welt der Menschen, Autos, Flugzeuge und Fabriken führen Erhöhungen in Verbrauch, Geschwindigkeit oder Tragfähigkeit dazu, dass die Hardware wächst und nicht schrumpft. Die Energie, die benötigt wird, um eine Tonne Menschen zu bewegen, eine Tonne Stahl oder Silizium zu erwärmen oder eine Tonne Nahrung anzubauen, wird durch Eigenschaften der Natur bestimmt, deren Grenzen durch die Gesetze der Schwerkraft, Trägheit, Reibung, Masse und Thermodynamik festgelegt sind – nicht durch clevere Software.

Dieses Papier beleuchtet die Physik der Energie, um zu veranschaulichen, warum es keine Möglichkeit gibt, dass die Welt einen kurzfristigen Übergang zu einer „neuen Energiewirtschaft“ durchläuft – oder durchlaufen kann.

Unter den Gründen sind:

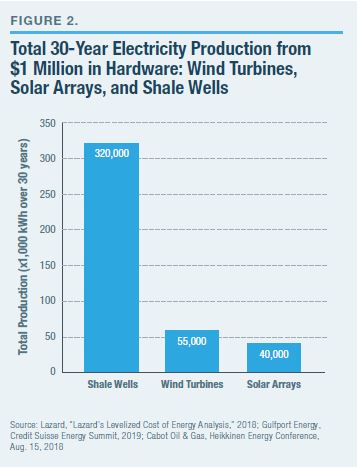

- Etwas so Bemerkenswertes wie Kohlenwasserstoffe in Bezug auf die Kombination von kostengünstiger, hochenergetischer Dichte, Stabilität, Sicherheit und Portabilität müssen Wissenschaftler erst noch entdecken, und Unternehmer müssen es erst noch erfinden. In der Praxis bedeutet dies, dass für den Gegenwert von 1 Million Dollar für Windturbinen oder Solarmodulen für die Energieversorgung jeweils über 30 Jahre Betrieb etwa 50 Millionen Kilowattstunden (kWh) produziert werden – während eine Million Dollar, die für eine Schieferförderplattform ausgegeben werden, über 30 Jahre hinweg genug Erdgas produzieren, um über 300 Millionen kWh zu erzeugen.

- Die Solartechnologien haben sich stark verbessert und werden weiterhin billiger und effizienter werden. Aber die Ära der 10-fachen Gewinne ist vorbei. Die physikalische Grenze für Silizium-Photovoltaik-(PV)-Zellen, das Shockley-Queisser Limit, ist eine maximale Umwandlung von 34% der Photonen in Elektronen; die beste kommerzielle PV-Technologie übersteigt heute bereits 26%.

- Auch die Windkrafttechnologie hat sich stark verbessert, aber auch hier bleiben keine 10-fachen Gewinne übrig. Die physikalische Grenze für eine Windturbine, die Betz-Grenze, ist eine maximale Erfassung von 60% der kinetischen Energie in der bewegten Luft; kommerzielle Turbinen überschreiten heute 40%.

- Die Jahresproduktion der Tesla Gigafactory, der weltweit größten Batteriefabrik, könnte drei Minuten Jahresstrombedarf der USA speichern. Es würde 1.000 Jahre Produktion erfordern, um genügend Batterien für den Strombedarf der USA von zwei Tagen herzustellen. Indessen werden 50-100 Kilogramm Material für jedes produzierte Kilogramm Batterie abgebaut, bewegt und verarbeitet.

Einführung

Ein wachsender Chor an Stimmen ermahnt sowohl die Öffentlichkeit als auch die Regierungspolitiker, sich der Notwendigkeit, der Unvermeidlichkeit des Übergangs der Gesellschaft zu einer „neuen Energiewirtschaft“ bewusst zu werden (Siehe Peak für Kohlenwasserstoffe gleich um die Ecke). Die Befürworter behaupten, dass der rasante technologische Wandel solche Durchbrüche erfahren wird und die erneuerbaren Energien so billig und schnell werden, dass kein wirtschaftliches Risiko besteht, wenn es darum geht, den Übergang zu einer Post-Kohlenwasserstoff-Welt zu beschleunigen, die nicht mehr viel, wenn überhaupt, Öl, Erdgas oder Kohle verbrauchen muss.

Im Mittelpunkt dieser Weltsicht steht die Annahme, dass der Energiesektor den gleichen technologischen Durchbrüchen ausgesetzt ist, die die Silicon Valley Technik in so viele andere Märkte gebracht hat. Tatsächlich sind Energieunternehmen der „Old Economy“ nach Ansicht von Befürwortern der neuen Energiewirtschaft eine schlechte Wahl für Investoren, da die Vermögenswerte von Kohlenwasserstoffunternehmen bald wertlos oder „gestrandet“ sein werden [1] Wetten auf Kohlenwasserstoffunternehmen sind heute wie Wetten auf Sears anstelle von Amazon vor einem Jahrzehnt.

Peak für Spitzenkohlenwasserstoffe gleich um die Ecke

“[Clean Tech ist] ein perfektes Beispiel für einen 10x exponentiellen Prozess, der fossile Brennstoffe in etwa einem Jahrzehnt vom Markt verschwinden lassen wird.“ -Tony Seba, Stanford Ökonom.

“Bisher haben die Beobachter vor allem auf die wahrscheinliche Wirksamkeit der Klimapolitik geachtet, nicht aber auf den laufenden und effektiv irreversiblen technologischen [Energie-] Wandel.“ – Jean-François Mercure, Universität Cambridge

“[Bis] 2030 könnten die Kosten [für Solar] so nahe bei Null liegen, dass sie praktisch kostenlos sind.“ – Sam Arie, UBS Research Analyst, UBS Research Analyst

“Die Welt erlebt eine globale Energiewende, die durch den technologischen Wandel und neue politische Prioritäten getrieben wird.“ – Europäische Union, Mission-Possible-Bericht für die G20

“Die globale Umstellung auf saubere Energie ist im Gang, aber es muss noch viel mehr getan werden.“ – Brief von 288 der weltweit größten Investoren an den G7-Gipfel

“Eine CO2-Steuer sollte jedes Jahr erhöht werden, bis die Ziele zur Emissionsreduktion erreicht sind, die die technologische Innovation und den Ausbau der großen Infrastruktur fördern.“ – Baker-Shultz-Plan, unterzeichnet von Ökonomen, Nobelisten, Fed-Reserve-Vorsitzenden, etc.

“Grüne Technologien, wie Batterien, Solar- und Windkraft, verbessern sich viel schneller, als viele glauben… Es ist die größte Umstrukturierung der Wirtschaft seit der industriellen Revolution.“ – Jeremy Grantham, Investor, Milliardär

“Die Substitution von Smartphones schien in den frühen 2000er Jahren nicht unmittelbarer zu sein als die groß angelegte Substitution von Energie.“ – Internationaler Währungsfonds

Quelle: Tony Seba, „Clean Disruption“ (Video), Stanford University, 2017; Jean-François Mercure zitiert in Steve Hanley, „Carbon Bubble About to Burst, Leaving Trillions in Stranded Assets Behind, Claims New Research“, Clean Technica, 5. Juni 2018; Sam Arie, „Renewables Are Primed to Enter the Global Energy Race“, Financial Times, Aug. 13, 2018; OECD, „Mission Possible“, Energy Transitions Commission, November 2018; Steve Hanley, „Vor dem G7-Treffen drängen die Investoren auf ein Ende der Kohleverstromung und der Subventionen für fossile Brennstoffe“, Clean Technica, 5. Juni 2018; „Economists‘ Statement on Carbon Dividenden; „Investing Prophet Jeremy Grantham Takes Aim at Climate Change“, Bloomberg, Jan. 17, 2019; Wall Street Journal, 16. Januar 2019 (Baker-Shultz-Plan); Internationaler Währungsfonds, „Riding the Energy Transition: Öl jenseits von 2040“, Mai 2017

„Mission Possible“, ein Bericht einer internationalen Energy Transitions Commission aus dem Jahr 2018, verdeutlichte diese wachsende Meinung auf beiden Seiten des Atlantiks. [2] Um den Energieverbrauch zu „dekarbonisieren“, fordert der Bericht die Welt auf, drei „ergänzende“ Maßnahmen zu ergreifen: den aggressiven Einsatz erneuerbarer Energien oder so genannter sauberer Technologien, die Verbesserung der Energieeffizienz und die Begrenzung des Energiebedarfs.

Dieses Rezept dürfte bekannt vorkommen, denn es ist identisch mit einem nahezu universellen energiepolitischen Konsens, der nach dem arabischen Ölembargo von 1973-74, das die Welt schockierte, entstand. Aber während die Energiepolitik des vergangenen halben Jahrhunderts von der Angst vor Ressourcenverknappung belebt wurde, besteht heute die Angst, dass die Verbrennung der reichlich vorhandenen Kohlenwasserstoffe der Welt gefährliche Mengen an Kohlendioxid in die Atmosphäre freisetzt.

Sicherlich zeigt die Geschichte, dass große Transitionen in der Energieversorgung möglich sind. Die Schlüsselfrage ist heute, ob die Welt an der Schwelle der nächsten steht.

Die kurze Antwort lautet: Nein. Es gibt zwei kritische Mängel an der These, dass die Welt bald auf Kohlenwasserstoffe verzichten kann. Erstens: Die physikalischen Realitäten lassen es nicht zu, dass sich die Energieversorgung so revolutionär verändert wie an den digitalen Grenzen. Zweitens: In fast einem Jahrhundert wurde keine grundlegend neue Energietechnologie entdeckt oder erfunden – und sicherlich nichts Analoges zur Erfindung des Transistors oder des Internets.

Bevor diese Mängel erläutert werden, ist es am besten, die Konturen der heutigen kohlenwasserstoffbasierten Energiewirtschaft zu verstehen und zu verstehen, warum ein Ersatz ein monumentales, wenn nicht sogar ein unmögliches Unterfangen wäre.

Mondlandungs-Politik und die Herausforderung der Dimensionen

Das Universum ist von Energie durchflutet. Für die Menschheit bestand die Herausforderung schon immer darin, Energie auf eine nützliche Weise zu liefern, die sowohl tolerierbar als auch dann verfügbar ist, wenn sie gebraucht wird, und nicht, wenn die Natur oder das Glück sie bietet. Ob Wind oder Wasser an der Oberfläche, Sonnenlicht von oben oder tief in der Erde vergrabene Kohlenwasserstoffe, die Umwandlung einer Energiequelle in nutzbare Energie erfordert immer kapitalintensive Hardware.

In Anbetracht der Weltbevölkerung und der Größe moderner Volkswirtschaften kommt es auf die Größe an. In der Physik muss man sich beim Versuch, ein System zu verändern, mit Trägheit und verschiedenen Widerstandskräften auseinandersetzen; es ist viel schwieriger, eine Boeing zu drehen oder zu stoppen, als eine Hummel. In einem Sozialsystem ist es viel schwieriger, die Richtung eines Landes zu ändern als eine lokale Gemeinschaft.

Die heutige Realität: Kohlenwasserstoffe – Öl, Erdgas und Kohle – machen 84% der weltweiten Energie aus, ein Anteil, der gegenüber 87% vor zwei Jahrzehnten nur geringfügig zurückgegangen ist (Abbildung 1) [3] In diesen zwei Jahrzehnten stieg der gesamte weltweite Energieverbrauch um 50%, was dem Wert von zwei ganzen USA entspricht [4].

Der geringe Rückgang des Kohlenwasserstoffanteils am Weltenergieverbrauch machte in diesem Zeitraum über 2 Billionen US-Dollar an kumulativen globalen Ausgaben für Alternativen erforderlich. [5] Der beliebte Anblick von mit Windturbinen geschmückten Feldern und mit Solarzellen bestückten Dächern ändert nichts daran, dass diese beiden Energiequellen heute weniger als 2% zur globalen Energieversorgung und 3% zur US-Energieversorgung beitragen.

Die Skalierungsherausforderung für jede Energiequellentransformation beginnt mit einer Beschreibung. Heute benötigen die Volkswirtschaften der Welt eine jährliche Produktion von 35 Milliarden Barrel Erdöl, plus das Energieäquivalent von weiteren 30 Milliarden Barrel Erdöl aus Erdgas und das Energieäquivalent von weiteren 28 Milliarden Barrel Erdöl aus Kohle. Optisch gesehen: Wenn all dieser Treibstoff in Form von Öl wäre, würden die Fässer eine Linie von Washington, D.C., nach Los Angeles bilden, und diese ganze Linie würde jede Woche um ein Washington-Denkmal höher werden.

Um Kohlenwasserstoffe in den nächsten 20 Jahren vollständig zu ersetzen, müsste die globale Produktion erneuerbarer Energien um das mindestens 90-fache steigen. [6] Zum Kontext: Es dauerte ein halbes Jahrhundert, bis die globale Öl- und Gasproduktion um das 10-fache expandierte. [7] Es ist eine Phantasie zu denken, abgesehen von den Kosten, dass jede neue Form der Energieinfrastruktur heute neunmal stärker expandieren könnte in weniger als der Hälfte der Zeit.

Wenn das ursprüngliche Ziel bescheidener wäre – sagen wir, Kohlenwasserstoffe nur in den USA und nur in der Stromerzeugung zu ersetzen – würde das Projekt eine industrielle Anstrengung erfordern, die über dem Mobilisierungsgrad des Zweiten Weltkriegs liegt. [8] Ein Übergang zu 100% kohlenwasserstofffreier Elektrizität bis 2050 würde ein US-Netzausbauprogramm erfordern, das 14-mal größer ist als die Netzausbaurate, die in den letzten fünfzig Jahren stattgefunden hat. [9] Um die Transformation abzuschließen, müsste diese Prometheussche Anstrengung mehr als verdoppelt werden, um die nichtelektrischen Sektoren anzugehen, in denen 70% der US-Kohlenwasserstoffe verbraucht werden. Und all das würde nur 16% des weltweiten Energieverbrauchs betreffen, nämlich den Anteil der USA.

Diese gewaltige Herausforderung löst eine gemeinsame Antwort aus: „Wenn wir einen Mann auf den Mond schicken können, können wir sicher auch … [die Lücke füllen mit jedem beliebigen ambitionierten Ziel].“ Doch die Transformation der Energiewirtschaft ist nicht so, als würde man ein paar Menschen ein paar Mal auf den Mond setzen. Es ist, als würde man die ganze Menschheit auf den Mond bringen – dauerhaft.

Die physikalisch bedingten Kostenrealitäten von Wind und Solar

Die Technologien, die die Vision der neuen Energiewirtschaft einrahmen, bestehen aus nur drei Dingen: Windmühlen, Solarmodule und Batterien. [10] Obwohl Batterien keine Energie produzieren, sind sie entscheidend dafür, dass die episodische Wind- und Sonnenenergie für den Einsatz in Haus, Gewerbe und Verkehr jederzeit zur Verfügung steht.

Doch Windmühlen und Sonnenenergie sind selbst keine „neuen“ Energiequellen. Die moderne Windturbine entstand vor 50 Jahren und wurde durch neue Materialien, insbesondere Glasfaser auf Kohlenwasserstoffbasis, ermöglicht. Die erste kommerziell nutzbare Solartechnologie datiert ebenfalls ein halbes Jahrhundert zurück, ebenso wie die Erfindung der Lithium-Batterie (durch einen Exxon-Forscher). [11]

Im Laufe der Jahrzehnte haben sich alle drei Technologien stark verbessert und sind um das Zehnfache günstiger geworden. [12] Abgesehen von den Subventionen erklärt diese Tatsache, warum die Nutzung von Wind/Solar in den letzten Jahrzehnten von einer Basis von im Wesentlichen Null so stark zugenommen hat.

Dennoch wird die Wind-, Solar- und Batterietechnik in Grenzen weiter verbessert. Diese Grenzen sind von großer Bedeutung, vor allem aufgrund des überwältigenden Energiebedarfs in der modernen Welt und der Realität der von Mutter Natur angebotenen Energiequellen.

Mit der heutigen Technologie werden Solarmodule im Wert von 1 Million Dollar über einen Zeitraum von 30 Jahren etwa 40 Millionen Kilowattstunden (kWh) produzieren (Abbildung 2). Eine ähnliche Kennzahl gilt für den Wind: Eine moderne Windturbine im Wert von 1 Million Dollar produziert in den gleichen 30 Jahren 55 Millionen kWh. [13] Währenddessen wird eine Hardware für eine Schieferförderplattform in den nächsten 30 Jahren genug Erdgas produzieren, um über 300 Millionen kWh zu erzeugen. [14] Das entspricht etwa 600% mehr Strom bei gleichem Investitionsaufwand für primärenergieerzeugende Hardware. [15] Die grundlegenden Unterschiede zwischen diesen Energiequellen lassen sich auch an der individuellen Ausstattung verdeutlichen. Für die Kosten einer einzelnen Schieferbohrung kann man zwei 500 Fuß hohe 2-Megawatt-(MW)-Windturbinen bauen. Diese beiden Windturbinen erzeugen eine kombinierte Leistung, die im Laufe der Jahre auf das Energieäquivalent von 0,7 Barrel Öl pro Stunde gemittelt wird. Das gleiche Geld, das für eine einzelne Schieferplattform ausgegeben wird, produziert 10 Barrel Öl pro Stunde oder sein Energieäquivalent in Erdgas, gemittelt über die Jahrzehnte. [16]

Die großen Unterschiede in der Produktion ergeben sich aus den inhärenten Unterschieden in der Energiedichte, die Merkmale der Natur sind, die gegen öffentliche Ansprüche oder staatliche Subventionen immun sind. Die hohe Energiedichte der physikalischen Chemie von Kohlenwasserstoffen ist einzigartig und gut verstanden, ebenso wie die Wissenschaft, die der niedrigen Energiedichte zugrunde liegt, die dem Oberflächensonnenlicht, den Windvolumina und der Geschwindigkeit innewohnt. [17] Unabhängig davon, was Regierungen vorschreiben, dass die Versorgungsunternehmen für diese Leistung zahlen sollen, wird die Menge der erzeugten Energie davon bestimmt, wie viel Sonnenlicht oder Wind über einen bestimmten Zeitraum verfügbar ist, und die Physik der Umwandlungswirkungsgrade von Photovoltaikzellen oder Windturbinen.

Solche Vergleiche zwischen Wind, Sonne und Erdgas veranschaulichen den Ausgangspunkt, um eine Rohstoffressource nutzbar zu machen. Doch damit irgend eine Form von Energie zu einer primären Energiequelle wird, ist zusätzliche Technologie erforderlich. Beim Gas gibt man notwendigerweise Geld für einen Turbogenerator aus, um den Kraftstoff in Netzstrom umzuwandeln. Für Wind/Solar sind Ausgaben für eine Form der Speicherung erforderlich, um episodischen Strom in nutzbaren 24/7-Strom umzuwandeln.

Die hohen Kosten für die Sicherstellung der Energieverfügbarkeit

Die Verfügbarkeit ist das kritischste Merkmal jeder Energieinfrastruktur, gefolgt vom Preis, gefolgt von der ewigen Suche nach sinkenden Kosten, ohne die Verfügbarkeit zu beeinträchtigen. Bis zum modernen Energiezeitalter war der wirtschaftliche und soziale Fortschritt durch den episodischen Charakter der Energieverfügbarkeit behindert worden. Deshalb stammen bisher mehr als 90% der amerikanischen Elektrizität und 99% der im Verkehr eingesetzten Energie aus Quellen, die jederzeit bei Bedarf problemlos Energie liefern können. [18]

In unserer datenzentrierten, zunehmend elektrifizierten Gesellschaft ist jederzeit verfügbare Energie unerlässlich. Aber wie bei allen Dingen schränkt die Physik die Technologien und die Kosten für die Bereitstellung der Verfügbarkeit ein. [19] Bei kohlenwasserstoffbasierten Systemen wird die Verfügbarkeit von den Kosten für Geräte dominiert, die Kraftstoff kontinuierlich für mindestens 8.000 Stunden pro Jahr und Jahrzehnte in Strom umwandeln können. In der Zwischenzeit ist es von Natur aus einfach, den zugehörigen Kraftstoff zu lagern, um erwartete oder unerwartete Nachfrageschübe oder Lieferausfälle in der Lieferkette aufgrund von Wetter oder Unfällen zu bewältigen.

Es kostet weniger als 1 $ pro Barrel, um Öl oder Erdgas (in Form von Öl-Energie-Äquivalenten) ein paar Monate lang zu lagern. [20] Die Lagerung von Kohle ist noch billiger. Daher ist es nicht verwunderlich, dass die USA zu jedem beliebigen Zeitpunkt im Durchschnitt etwa ein bis zwei Monate nationale Nachfrage für jede Art von Kohlenwasserstoff haben. [21]

Indessen kostet es mit Batterien etwa 200 Dollar, die Energie, die einem Barrel Öl entspricht, zu speichern. [22] So kann anstelle von Monaten kaum zwei Stunden nationaler Strombedarf in der Summe aller netzbetriebenen Großbatterien plus aller Batterien in den heute in Amerika existierenden 1 Million Elektroautos gespeichert werden. [23]

Bei Wind/Solar sind die Merkmale, die die Verfügbarkeitskosten dominieren, im Vergleich zu Kohlenwasserstoffen gerade umgekehrt. Während Solaranlagen und Windkraftanlagen zwar verschleißen und ebenfalls gewartet werden müssen, sind die Physik und damit die zusätzlichen Kosten dieses Verschleißes weniger anspruchsvoll als bei Verbrennungsmotoren. Die komplexe und vergleichsweise instabile Elektrochemie von Batterien stellt jedoch eine von Natur aus teurere und weniger effiziente Möglichkeit dar, Energie zu speichern und ihre Verfügbarkeit sicherzustellen.

Da Kohlenwasserstoffe so einfach zu lagern sind, können leer laufende konventionelle Kraftwerke aktiviert – hoch und runtergefahren – werden, um dem zyklischen Strombedarf zu folgen. Windkraftanlagen und Solaranlagen können nicht aktiviert werden, wenn kein Wind oder Sonne vorhanden ist. In der Geophysik produzieren sowohl wind- als auch sonnengetriebene Maschinen im Jahresdurchschnitt etwa 25%-30% der Zeit, oft weniger. [24] Konventionelle Kraftwerke haben jedoch eine sehr hohe „Verfügbarkeit“ im Bereich von 80%-95% und oft höher. [25]

Ein Wind-/Solarnetz müsste so dimensioniert sein, dass es sowohl die Spitzennachfrage abdeckt als auch über den Spitzenbedarf hinaus über genügend zusätzliche Kapazität verfügt, um zusätzlichen Strom zu produzieren und zu speichern, wenn Sonne und Wind verfügbar sind. Das bedeutet im Durchschnitt, dass ein reines Wind-/Solarsystem notwendigerweise etwa die dreifache Kapazität eines Kohlenwasserstoffnetzes aufweisen müsste, d.h. man muss 3 kW Wind-/Solaranlage pro 1 kW eliminierter Verbrennungsanlage bauen. Das bedeutet direkt einen dreifachen Kostennachteil, selbst wenn die Pro-kW-Kosten gleich wären. [26]

Selbst diese notwendige zusätzliche Kapazität würde nicht ausreichen. Meteorologische und betriebliche Daten zeigen, dass die durchschnittliche monatliche Wind- und Sonnenstromerzeugung während der jeweiligen „Nebensaison“ der einzelnen Quellen bis auf die Hälfte absinken kann. [27]

Der Mythos der Netzparität

Wie passen diese Kapazitäts- und Kostennachteile zur Behauptung, dass Wind und Sonne bereits auf oder nahe der „Netzparität“ mit konventionellen Stromquellen liegen? Die U.S. Energy Information Agency (EIA) und andere ähnliche Analysen berichten von „nivellierten Energiekosten“ (LCOE) für alle Arten von Stromerzeugungstechnologien. In den LCOE-Berechnungen der EIA wird der Strom aus einer Windturbine oder einer Solaranlage mit 36% bzw. 46% teurer berechnet als aus einer Erdgas-Turbine, d.h. mit annähernder Parität. [28] Die EIA erklärt jedoch in einem kritischen und selten erwähnten Vorbehalt: „Die LCOE-Werte für disponierbare und nicht disponierbare Technologien sind in den Tabellen separat aufgeführt, da ein Vergleich sorgfältig durchgeführt werden muss“ [29] (Hervorhebung hinzugefügt). Anders ausgedrückt, berücksichtigen die LCOE-Berechnungen nicht die Vielzahl der realen, wenn auch versteckten Kosten, die für den Betrieb einer zuverlässigen Energieinfrastruktur rund um die Uhr und an 365 Tagen im Jahr erforderlich sind – oder insbesondere eines Netzes, das nur Wind/Solar verwendet.

Der LCOE betrachtet die Hardware isoliert und ignoriert dabei die realen Systemkosten, die für die Versorgung mit 24/7-Strom unerlässlich sind. Ebenso irreführend ist, dass eine LCOE-Berechnung trotz ihrer Illusion von Präzision auf einer Vielzahl von Annahmen und Schätzungen beruht, die zur Diskussion stehen, wenn sie die Analyse nicht sogar verzerren.

So geht beispielsweise ein LCOE davon aus, dass die zukünftigen Kosten konkurrierender Kraftstoffe – insbesondere von Erdgas – deutlich steigen werden. Das bedeutet aber, dass der LCOE eher eine Prognose als eine Berechnung ist. Dies ist wichtig, da „nivellierte Kosten“ aus einer solchen Prognose einen angeblichen Durchschnittspreis über einen längeren Zeitraum berechnet. Die Annahme, dass die Gaspreise steigen werden, steht im Widerspruch zu der Tatsache, dass sie in den letzten zehn Jahren gesunken sind, und den Beweisen, dass niedrige Preise auf absehbare Zeit die neue Normalität sind. [30] Die Anpassung der LCOE-Berechnung an eine Zukunft, in der die Gaspreise nicht steigen, erhöht den LCOE-Kostenvorteil von Erdgas gegenüber Wind/Solar radikal.

Ein LCOE beinhaltet ein noch subjektiveres Merkmal, den so genannten „Diskontsatz“, der eine Möglichkeit bietet, den heutigen Wert des Geldes mit der Zukunft zu vergleichen. Ein niedriger Diskontsatz hat den Effekt, dass ein Ergebnis gekippt wird, um es attraktiver zu machen, heute wertvolles Kapital auszugeben, um ein zukünftiges (theoretisches) Problem zu lösen. Befürworter niedriger Diskontierungssätze gehen im Wesentlichen von einem langsamen Wirtschaftswachstum aus. [31]

Ein hoher Diskontsatz setzt effektiv voraus, dass eine zukünftige Gesellschaft viel reicher sein wird als heute (ganz zu schweigen von besserer Technologie). [32] Die Arbeit des Ökonomen William Nordhaus auf diesem Gebiet, in der er sich für einen hohen Diskontsatz einsetzt, brachte ihm 2018 den Nobelpreis ein.

Ein LCOE erfordert auch eine Annahme über durchschnittliche jahrzehntelange Kapazitätsfaktoren, den Anteil der Zeit, den die Ausrüstung tatsächlich arbeitet (d.h. die tatsächliche, nicht theoretische Zeit, die die Sonne scheint und der Wind weht). Die EIA geht beispielsweise von 41% bzw. 29% Kapazitätsfaktoren für Wind und Sonne aus. Die Daten aus den laufenden Wind- und Solarparks zeigen jedoch tatsächliche mittlere Kapazitätsfaktoren von 33% und 22%. [33] Der Unterschied zwischen der Annahme eines 40%igen, aber tatsächlich erlebten 30%igen Kapazitätsfaktors bedeutet, dass über die 20-jährige Lebensdauer einer 2-MW-Windturbine 3 Millionen Dollar an Energieproduktion, die in den Finanzmodellen angenommen wurden, nicht existieren werden – und das für eine Anlage mit einem Anfangsinvestitionsvolumen von etwa 3 Millionen Dollar.

Die Kapazitätsfaktoren für Windparks in den USA haben sich in den letzten zwei Jahrzehnten verbessert, allerdings mit einer langsamen Rate von etwa 0,7% pro Jahr. [34] Diese Steigerung ist vor allem auf die Reduktion der Anzahl der Turbinen pro Hektar zurückzuführen, die versuchen, bewegte Luft einzufangen, was zu einem Anstieg der durchschnittlichen Flächennutzung pro Windkrafteinheit um etwa 50% führt.

LCOE-Berechnungen beinhalten vernünftigerweise Kosten für Dinge wie Steuern, die Kosten für Kredite und Instandhaltung. Aber auch hier geben mathematische Ergebnisse den Anschein von Präzision und verbergen Annahmen. So können beispielsweise die Annahmen über die Instandhaltungskosten und die langfristige Leistung von Windkraftanlagen zu optimistisch sein. Daten aus Großbritannien, das auf dem windgünstigen Weg weiter voran geschritten ist als die USA, deuten auf eine weitaus schnellere Degradation (weniger Strom pro Turbine) als ursprünglich prognostiziert hin. [35]

Um mindestens ein Problem mit der Verwendung von LCOE als Instrument anzugehen, hat die Internationale Energieagentur (IEA) kürzlich die Idee eines „wert-angepassten“ LCOE oder VALCOE vorgeschlagen, die die Elemente der Flexibilität und die wirtschaftlichen Auswirkungen der Aktivierungsfähigkeit berücksichtigt. IEA-Berechnungen mit einer VALCOE-Methode ergaben beispielsweise Kohlekraftwerke, die weitaus billiger waren als Solarstrom, wobei die Kostennachteile mit steigendem Anteil der solaren Erzeugung im Netz zunahmen. [36]

Man würde erwarten, dass lange bevor ein Netz zu 100% aus Wind/Solar besteht, die oben beschriebenen Arten von realen Kosten bereits sichtbar sein sollten. Zufällig haben wir, unabhängig von vermeintlichen LCOEs, Belege für die wirtschaftlichen Auswirkungen, die sich aus der verstärkten Nutzung von Wind- und Solarenergie ergeben.

Die versteckten Kosten eines „grünen“ Netzes

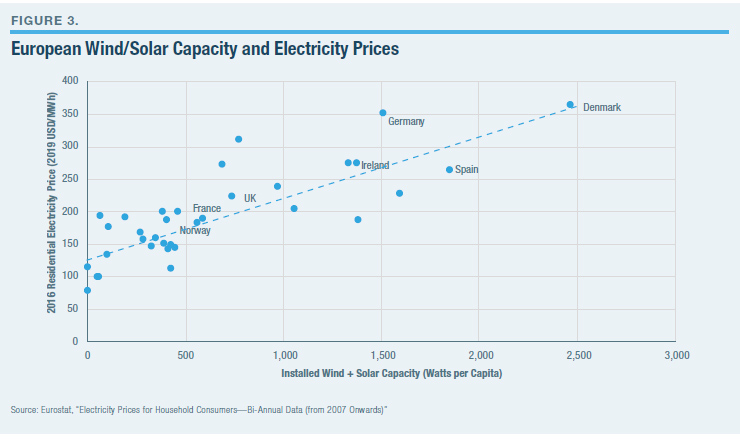

Subventionen, Steuerpräferenzen und Mandate können die realen Kosten verbergen, aber wenn sich genug davon ansammelt, dann sollte der Effekt in den Gesamtsystemkosten sichtbar sein. Und das ist er auch. In Europa zeigen die Daten, dass je höher der Anteil von Wind/Solar, desto höher die durchschnittlichen Kosten für Netzstrom sind (Abbildung 3).

Deutschland und Großbritannien, die den Weg der „neuen Energie“ schon sehr weit gegangen sind, haben in den letzten zwei Jahrzehnten die durchschnittlichen Strompreise um 60%-110% angehoben. [37] Das gleiche Muster – mehr Wind/Solar und höhere Stromrechnungen – ist in Australien und Kanada sichtbar. [38]

Da der Anteil der Windenergie pro Kopf in den USA immer noch nur einen kleinen Teil von dem in den meisten europäischen Ländern ausmacht, sind die Kostenauswirkungen auf die amerikanischen Verbraucher weniger dramatisch und weniger sichtbar. Dennoch sind die durchschnittlichen US-Elektrohaushaltskosten in den letzten 15 Jahren um rund 20% gestiegen. [39] Das hätt nicht der Fall sein sollen. Die durchschnittlichen Strompreise hätten sinken sollen, nicht steigen.

Der Grund ist folgender: Kohle und Erdgas lieferten in diesem Zeitraum von 15 Jahren zusammen etwa 70% der Elektrizität. [40] Der Ölpreis macht etwa 60%-70% der Kosten für die Stromerzeugung bei der Verwendung von Kohlenwasserstoffen aus. [41] Somit hängt etwa die Hälfte der durchschnittlichen Kosten für den amerikanischen Strom von den Kohle- und Gaspreisen ab. Der Preis für diese beiden Kraftstoffe ist in diesem Zeitraum von 15 Jahren um mehr als 50 % gesunken. Die Versorgungskosten, insbesondere für den Kauf von Gas und Kohle, sind allein in den letzten zehn Jahren um rund 25% gesunken. Mit anderen Worten, die Kosteneinsparungen durch die Schiefergas-Revolution haben die Verbraucher bisher deutlich von noch höheren Strompreiserhöhungen isoliert.

Der zunehmende Einsatz von Wind/Solar führt zu einer Vielzahl von versteckten, physikalisch bedingten Kosten, die in der Versorgungswirtschaft oder der staatlichen Rechnungslegung selten anerkannt werden. Wenn beispielsweise große Mengen an Strom schnell, wiederholt und unvorhersehbar hoch und runtergefahren werden, erhöhen sich die Herausforderungen und die Kosten, die mit dem „Ausgleich“ eines Netzes (d.h. dem Verhindern eines Ausfalls) verbunden sind, erheblich. OECD-Analysten schätzen, dass mindestens ein Teil dieser „unsichtbaren“ Kosten, die dem Netz auferlegt werden, 20%-50% zu den Kosten der Netzkilowattstunden beiträgt. [42]

Darüber hinaus führt die Umkehrung der Rolle der bestehenden Kraftwerke des Netzes von Primär- auf Backup-Kraftwerke für Wind/Solar zu anderen realen, aber nicht verteilten Kosten, die sich aus der physikalischen Realität ergeben. Erhöhte Lastzyklen konventioneller Kraftwerke erhöhen die Verschleiß- und Wartungskosten. Es reduziert auch die Auslastung dieser teuren Anlagen, was bedeutet, dass die Kapitalkosten auf weniger produzierte kWh verteilt werden – wodurch die Kosten für jede dieser Kilowattstunden arithmetisch erhöht werden. [43]

Wenn dann der Anteil der episodischen Energie signifikant wird, steigt das Potenzial für komplette Systemausfälle. Das ist zweimal passiert, nachdem der Wind unerwartet nachgelassen hat (wobei einige Kunden in einigen Gebieten tagelang ohne Strom waren) im Bundesstaat Südaustralien, der über 40% seines Stroms aus Wind bezieht. [44]

Nach einem Totalausfall des Systems in Südaustralien im Jahr 2018 installierte Tesla, mit viel Medienhype, die weltweit größte „Farm“ für Lithium-Batterien in diesem Netz. [45] Um Südaustralien einen halben Tag lang ohne Wind in Betrieb zu halten, wären 80 solcher „größten“ Tesla-Batteriefarmen erforderlich, und das auf einem Netz, das nur 2,5 Millionen Menschen versorgt.

Ingenieure haben andere Möglichkeiten, Zuverlässigkeit zu erreichen; sie verwenden altmodische riesige Dieselmotor-Generatoren als Backup (Motoren, die im Wesentlichen dieselben sind wie die, die Kreuzfahrtschiffe antreiben oder die zur Sicherung von Rechenzentren verwendet werden). Ohne Fanfaren, wegen der zunehmenden Nutzung von Wind, haben US-Versorger in rasantem Tempo Netz-Skalen-Motoren installiert. Das Netz verfügt nun über mehr als 4 Milliarden Dollar an Stromerzeugern im Versorgungsbereich, die für etwa 100 Kreuzfahrtschiffe ausgelegt sind, und es werden noch viele weitere folgen. Die meisten verbrennen Erdgas, obwohl viele davon mit Öl befeuert werden. In den letzten zwei Jahrzehnten wurden dreimal so viele so große Kolbenmotoren in das amerikanische Netz aufgenommen wie im halben Jahrhundert zuvor. [46]

Alle diese Kosten sind real und werden nicht auf Wind- oder Solargeneratoren umgelegt. Doch die Stromverbraucher bezahlen sie. Eine Möglichkeit, zu verstehen, was vor sich geht: Die Verwaltung von Netzen mit versteckten Kosten, die den nicht begünstigten Spielern auferlegt werden, wäre wie die Erhebung von Gebühren für den Autobahnverschleiß durch schwere Lkw bei gleichzeitiger Subventionierung der Kosten für den Kraftstoffverbrauch dieser Lkw.

Das Problem mit der Wind- und Sonnenenergie läuft auf einen einfachen Punkt hinaus: Ihr Nutzen ist auf nationaler Ebene als Haupt- oder Primärbrennstoffquelle für die Stromerzeugung unpraktisch. Wie bei jeder Technologie ist es möglich, die Grenzen der praktischen Anwendung zu überschreiten, aber in der Regel nicht sinnvoll oder kostengünstig. Hubschrauber bieten eine aufschlussreiche Analogie.

Die Entwicklung eines praktischen Hubschraubers in den 1950er Jahren (vier Jahrzehnte nach seiner Erfindung) inspirierte zur weit verbreiteten Utopie über diese Technologie, dass sie den Personenverkehr revolutionieren werde. Heute ist die Herstellung und der Einsatz von Hubschraubern eine milliardenschwere Nischenindustrie, die nützliche und oft vitale Dienstleistungen anbietet. Aber man würde heute sowenig auf die Idee kommen, Hubschrauber für regelmäßige atlantische Reisen benutzen zu wollen – obwohl mit aufwändiger Logistik machbar – wie einen Kernreaktor für den Antrieb eines Zuges oder Photovoltaiksysteme für die Versorgung eines ganzen Landes einsetzen zu wollen.

Batterien können das Netz oder den Planeten nicht retten

Batterien sind ein zentrales Merkmal der neuen energiewirtschaftlichen Ambitionen. Es würde in der Tat die Welt revolutionieren, eine Technologie zu finden, die Strom so effektiv und kostengünstig speichern könnte wie beispielsweise Öl in einem Fass oder Erdgas in einer unterirdischen Höhle. [47] Solche Stromspeicher-Hardware würde es unnötig machen, selbst heimische Kraftwerke zu bauen. Man könnte sich eine OKEC (Organization of Kilowatt-Hour Exporting Countries) vorstellen, die Elektronenfässer aus Ländern, in denen die Kosten für die Befüllung dieser „Fässer“ am niedrigsten wären, etwa Solaranlagen in der Sahara, Kohlebergwerke in der Mongolei (außerhalb der Reichweite westlicher Regulierungsbehörden) oder die großen Flüsse Brasiliens, verschifft.

Doch in dem Universum, in dem wir leben, sind die Kosten für die Speicherung von Energie in netzfähigen Batterien, wie bereits erwähnt, etwa 200-fach höher als die Kosten für die Speicherung von Erdgas zur Stromerzeugung, wenn es gebraucht wird. [48] Deshalb speichern wir zu jedem beliebigen Zeitpunkt monatelange nationale Energieversorgung in Form von Erdgas oder Öl.

Batteriespeicherung ist eine ganz andere Sache. Betrachten Sie Tesla, den bekanntesten Batteriehersteller der Welt: Tesla-Batterien im Wert von 200.000 US-Dollar, die zusammen über 9.000 Kilogramm wiegen, werden benötigt, um das Energieäquivalent von einem Barrel Öl zu speichern. [49] Ein Barrel Öl wiegt indessen 136 Kilogramm und kann in einem 20-Dollar-Tank gelagert werden. Das sind die Realitäten der heutigen Lithium-Batterien. Selbst eine Verbesserung der zugrunde liegenden Batterieökonomie und -technologie um 200% wird eine solche Lücke nicht schließen.

Dennoch begrüßen die politischen Entscheidungsträger in Amerika und Europa mit Begeisterung Programme und Subventionen, um die Produktion und den Einsatz von Batterien in Netz-Grössenordnungen erheblich auszuweiten. [50] Erstaunliche Mengen an Batterien werden benötigt, um die Energienetze der Länder aufrechtzuerhalten – und der Umfang des Bergbaus, der für die zugrunde liegenden Rohstoffe erforderlich ist, wäre episch. Zumindest für die USA, wo die Materialien abgebaut werden und wo Batterien hergestellt werden, würden die Importe radikal zunehmen. Es folgt eine Perspektive auf jede dieser Realitäten.

Wie viele Batterien würde es brauchen, um die Nation zu beleuchten?

Ein vollständig auf Wind und Sonne basierendes Netz erfordert über die Vorbereitung auf die normale tägliche Variabilität von Wind und Sonne hinaus auch die Vorbereitung auf die Häufigkeit und Dauer von Perioden, in denen nicht nur viel weniger Wind und Sonnenlicht kombiniert würden, sondern auch für Perioden, in denen es keines von beiden geben würde. Obwohl ungewöhnlich, ist eine solche kombinierte kontinentale Wolkendecke am Tag ohne nennenswerten Wind nirgendwo, oder in der Nacht ohne Wind, mehr als ein Dutzend Mal im vergangenen Jahrhundert aufgetreten – effektiv einmal pro Jahrzehnt. Bei diesen Gelegenheiten wäre ein kombiniertes Wind-/Solarnetz nicht in der Lage, auch nur einen winzigen Teil des Strombedarfs des Landes zu decken. Es gab auch häufige einstündige Perioden, in denen 90% der nationalen Stromversorgung entfallen wären. [51]

Wie viele Batterien wären also erforderlich, um beispielsweise nicht zwei Monate, sondern zwei Tage lang den Strom des Landes zu speichern? Die 5 Milliarden Tesla „Gigafactory“ in Nevada ist derzeit die größte Batterieherstellungsanlage der Welt. [52] Ihre jährliche Gesamtproduktion könnte den jährlichen Strombedarf der USA um drei Minuten speichern. Um eine Menge an Batterien herzustellen, die den Bedarf der USA für zwei Tage decken könnte, müsste die Gigafactory-Produktion 1.000 Jahre betragen.

Die Befürworter von Wind/Solar schlagen vor, die Batterienutzung durch enorm lange Übertragungsleitungen zu minimieren, wenn man beobachtet, dass es irgendwo immer windig oder sonnig ist. Obwohl theoretisch machbar (wenn auch nicht immer richtig, auch nicht immer auf Länderebene), stellt die Dauer der Übertragung, die erforderlich ist, um einen „immer“ sonnigen/windigen Ort zu erreichen, auch eine erhebliche Zuverlässigkeits- und Sicherheitsherausforderung dar. (Und die Fernübertragung von Energie über Kabel ist doppelt so teuer wie über Pipelines.) [53]

Der Bau großer Mengen von Batterien hätte epische Auswirkungen auf den Bergbau

Eine wichtige Begründung für das Streben nach einer neuen Energiewirtschaft ist die Reduzierung der Umweltexternalitäten durch die Verwendung von Kohlenwasserstoffen. Während der Fokus heutzutage hauptsächlich auf den vermeintlichen Langzeiteffekten von Kohlendioxid liegt, sind alle Formen der Energieerzeugung mit verschiedenen unregulierten Externalitäten verbunden, die mit dem Abbau, der Bewegung und der Verarbeitung von Mineralien und Materialien verbunden sind.

Die radikale Steigerung der Batterieproduktion wird sich drastisch auf den Bergbau auswirken, ebenso wie auf die Energie, die für den Zugang, die Verarbeitung und den Transport von Mineralien verwendet wird, und auf die Energie, die für den eigentlichen Batterieherstellungsprozess benötigt wird. Etwa 55 Kilogramm Batterien werden benötigt, um die Energie zu speichern, die derjenigen in einem Kilogramm Kohlenwasserstoffe entspricht. Indessen werden 50-100 Kilogramm verschiedener Materialien für ein Kilogramm produzierte Batterie abgebaut, bewegt und verarbeitet. [54] Solche zugrunde liegenden Realitäten führen zu enormen Mengen an Mineralien – wie Lithium, Kupfer, Nickel, Graphit, Seltene Erden und Kobalt -, die aus der Erde gewonnen werden müssten, um Batterien für Netze und Autos herzustellen. [55] Eine batteriezentrierte Zukunft bedeutet einen Weltbergbau von Gigatonnen mehr Materialien. [56] Und das sagt nichts über die Gigatonnen an Materialien aus, die auch für die Herstellung von Windkraftanlagen und Solaranlagen benötigt werden. [57]

Auch ohne eine neue Energiewirtschaft wird der für die Herstellung von Batterien erforderliche Abbau bald die Produktion vieler Mineralien dominieren. Die Produktion von Lithiumbatterien macht heute bereits etwa 40% bzw. 25% des gesamten Lithium- und Kobaltbergbaues aus. [58] In einer Allbatterie-Zukunft müsste der globale Bergbau um mehr als 200% für Kupfer, um mindestens 500% für Mineralien wie Lithium, Graphit und Seltene Erden und weit mehr als der für Kobalt expandieren. [59]

Hinzu kommen die Kohlenwasserstoffe und die Elektrizität, die benötigt werden, um alle Bergbauaktivitäten durchzuführen und die Batterien selbst herzustellen. Grob gesagt, benötigt es das Energieäquivalent von etwa 100 Barrel Öl, um eine Menge von Batterien herzustellen, die ein einzelnes Barrel öläquivalenter Energie speichern können. [60]

Angesichts der regulatorischen Feindseligkeit gegenüber dem Bergbau auf dem US-Kontinent garantiert eine batteriebetriebene Energiezukunft praktisch mehr Bergbau an anderer Stelle und steigende Importabhängigkeiten für die USA. Die meisten relevanten Minen auf der Welt befinden sich in Chile, Argentinien, Australien, Russland, dem Kongo und China. Insbesondere die Demokratische Republik Kongo produziert 70% des globalen Kobalts, und China veredelt 40% dieser Produktion für die Welt. [61]

China dominiert bereits die globale Batterieherstellung und ist auf dem besten Weg, bis 2020 fast zwei Drittel der gesamten Produktion zu liefern. [62] Die Relevanz für die Vision der neuen Energiewirtschaft: 70% des chinesischen Netzes werden heute von Kohle gespeist und werden bis 2040 immer noch 50% betragen. [63] Das bedeutet, dass über die Lebensdauer der Batterien mehr Kohlendioxidemissionen bei der Herstellung entstehen würden, als durch den Einsatz dieser Batterien, z.B. als Ersatz für Verbrennungsmotoren, ausgeglichen würden. [64]

Die Umstellung des Personentransports von der Kohlenwasserstoffverbrennung auf batteriebetriebene Fahrzeuge ist eine weitere zentrale Säule der neuen Energiewirtschaft. Von Elektrofahrzeugen (EFs) wird erwartet, dass sie nicht nur Erdöl auf der Straße ersetzen, sondern auch als Backup-Speicher für das Stromnetz dienen sollen. [65]

Lithium-Batterien haben es endlich ermöglicht, dass EFs einigermaßen praktisch einsetzbar sind. Tesla, das in Amerika inzwischen mehr Autos der Spitzenpreiskategorie verkauft als Mercedes-Benz, hat die Hersteller der Welt dazu inspiriert, attraktive batteriebetriebene Fahrzeuge zu produzieren. [66] Das hat die bürokratischen Bestrebungen nach einem völligen Verbot des Verkaufs von Verbrennungsmotoren vor allem in Deutschland, Frankreich, Großbritannien und, wenig überraschend, Kalifornien verstärkt.

Ein solches Verbot ist nicht leicht vorstellbar. Optimisten prognostizieren, dass die Zahl der Elektrofahrzeuge in zwei Jahrzehnten von heute fast 4 Millionen auf 400 Millionen steigen wird. [67] Eine Welt mit 400 Millionen Elektrofahrzeugen bis 2040 würde die globale Ölnachfrage um kaum 6% senken. Das klingt kontraintuitiv, aber die Zahlen sind einfach. Es gibt heute etwa 1 Milliarde Autos, und sie verbrauchen etwa 30% des weltweiten Öls [68] (Schwerlaster, Luftfahrt, Petrochemie, Wärme usw. nutzen den Rest.) Bis 2040 würde es schätzungsweise 2 Milliarden Autos auf der Welt geben. Vierhundert Millionen EFs würden 20% aller Autos auf der Straße ausmachen – was etwa 6% des Erdölbedarfs ersetzen würde.

Auf jeden Fall stellen Batterien keine Revolution in der persönlichen Mobilität dar, die gleichbedeutend wäre mit, etwa, dem Wechsel vom Kinderwagen zum Auto – eine Analogie, die gezogen worden ist. [69] Das Fahren mit einem EF ist eher vergleichbar mit der Änderung des Pferdefutters und dem Import von neuem Futter.

Moores Gesetz falsch angewandt

Angesichts all der oben beschriebenen Realitäten in Bezug auf grüne Technologien glauben die Enthusiasten der neuen Energiewirtschaft dennoch, dass echte Durchbrüche noch bevorstehen und sogar unvermeidlich sind. Denn, so wird behauptet, die Energietechnik wird der gleichen Entwicklung folgen wie in den letzten Jahrzehnten bei Computer und Kommunikation. Die Welt werde noch das Äquivalent eines Amazon oder „Apple der sauberen Energie“ erleben. [70]

Diese Idee ist verführerisch wegen der erstaunlichen Fortschritte in den Siliziumtechnologien, die so wenige Prognostiker vor Jahrzehnten erwartet haben. Es ist eine Idee, die alle Vorsicht, dass Wind/Solar/Batterien heute zu teuer sind, widerlegt – eine solche Vorsicht wird als töricht und kurzsichtig angesehen, analog zu der Behauptung von ungefähr 1980, dass sich der Durchschnittsbürger nie einen Computer werde leisten können. Oder im Jahr 1984 (dem Jahr, in dem das erste Handy der Welt in den Verkauf kam) zu sagen, dass eine Milliarde Menschen ein Handy besitzen würden, als es € 8.000 (in heutigen Euro) kostete. Es war ein ein Kilo schwerer „Ziegelstein“ mit einer 30-minütigen Gesprächszeit.

Die heutigen Smartphones sind nicht nur viel billiger, sie sind auch viel leistungsfähiger als ein raumgroßer IBM-Mainframe von vor 30 Jahren. Diese Transformation entstand, weil die Ingenieure die Größe und den Energiebedarf der Transistoren unaufhaltsam reduzierten und damit ihre Anzahl pro Chip etwa alle zwei Jahre verdoppelten – der nach Intel-Mitbegründer Gordon Moore benannte Trend „Moores Gesetz“.

Der kombinierte Effekt dieser Art von Fortschritt hat in der Tat eine Revolution ausgelöst. In den letzten 60 Jahren hat Moores Gesetz die Effizienz der Nutzung von Energie durch Logikmaschinen um mehr als das Milliardenfache verbessert. [71] Aber eine ähnliche Transformation in der Erzeugung oder Speicherung von Energie ist nicht nur unwahrscheinlich, sondern auch mit der Physik, die wir heute kennen, nicht möglich.

In der Welt der Menschen, Autos, Flugzeuge und großen Industriesysteme führt eine Erhöhung der Geschwindigkeit oder Tragfähigkeit dazu, dass die Hardware wächst, nicht schrumpft. Die Energie, die benötigt wird, um eine Tonne Menschen zu bewegen, eine Tonne Stahl oder Silizium zu erhitzen oder eine Tonne Nahrung anzubauen, wird durch Eigenschaften der Natur bestimmt, deren Grenzen durch die Gesetze der Schwerkraft, Trägheit, Reibung, Masse und Thermodynamik festgelegt sind.

Wenn Verbrennungsmotoren zum Beispiel die Art von Skalierungseffizienz erreichen könnten, die Computer seit 1971 haben – das Jahr, in dem die erste weit verbreitete integrierte Schaltung von Intel vorgestellt wurde – würde ein Automotor tausendmal mehr PS erzeugen und auf die Größe einer Ameise schrumpfen. [72] Mit einem solchen Motor könnte ein Auto tatsächlich sehr rasch fliegen.

Wenn die Photovoltaik nach dem Moore’schen Gesetz skalierte, würde eine einzige stempelgroße Solaranlage das Empire State Building mit Strom versorgen. Wenn Batterien nach Moore’s Gesetz skalierten, würde eine Batterie im Format eines Buches, die drei Cent kostet, einen A380 nach Asien bringen könnten.

Doch leider funktioniert die Physik des Antriebs oder der Energieerzeugung nur in der Welt der Comics so. In unserem Universum skaliert Energie in die andere Richtung.

Ein ameisengroßer Motor – der schon gebaut wurde – produziert etwa 100.000 mal weniger Leistung als ein Prius. Eine Solar-PV-Anlage in Ameisengröße (ebenfalls realisierbar) produziert tausendfach weniger Energie als die biologischen Muskeln einer Ameise. Das Energieäquivalent des Flugtreibstoffs, der tatsächlich von einem Flugzeug verwendet wird, das nach Asien fliegt, würde Tesla-Batterien im Wert von 60 Millionen Dollar erfordern, die fünfmal mehr wiegen als dieses Flugzeug. [73]

Die Herausforderung, Informationen mit möglichst wenig Energie zu speichern und zu verarbeiten, unterscheidet sich von der Herausforderung, Energie zu erzeugen oder physische Objekte zu bewegen oder umzugestalten. Die beiden Bereiche umfassen unterschiedliche Gesetze der Physik.

Die Welt der Logik wurzelt darin, die Tatsache des binären Zustands eines Schalters einfach zu kennen und zu speichern ist – d.h. ob er ein- oder ausgeschaltet ist. Logik-Apparate erzeugen keine physische Aktion, sondern sind darauf ausgelegt, die Idee der Zahlen Null und Eins zu manipulieren. Im Gegensatz zu Motoren, die Menschen transportieren, können Logik-Apparate Software verwenden, um Dinge wie die Komprimierung von Informationen durch clevere Mathematik zu erreichen und so den Energieverbrauch zu reduzieren. In der Welt von Mensch und Hardware gibt es keine vergleichbaren Kompressionsmöglichkeiten.

Natürlich werden sich die Kosten und Leistungen von Windkraftanlagen, Solarzellen und Batterien weiter deutlich verbessern, ebenso wie Bohrgeräte und Verbrennungsturbinen (ein Thema, das als nächstes behandelt wird). Und natürlich wird die Informationstechnologie des Silicon Valley wichtige, ja sogar dramatische Effizienzsteigerungen bei der Produktion und dem Management von Energie und physischen Gütern mit sich bringen (eine Perspektive, die auch im Folgenden angesprochen wird). Aber die Ergebnisse werden nicht so wunderbar sein wie die Erfindung des integrierten Schaltkreises oder die Entdeckung von Erdöl oder Kernspaltung.

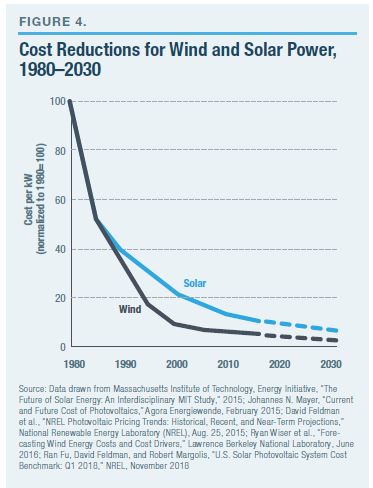

Die erneuerbare Asymptote hinuntergleiten

Die Prognosen für einen anhaltend schnellen Rückgang der Kosten für Wind/Solar/Batterien sind inspiriert von den Gewinnen, die diese Technologien bereits erzielt haben. In den ersten beiden Jahrzehnten der Kommerzialisierung, nach den 1980er Jahren, wurden die Kosten um das Zehnfache gesenkt. Aber der Weg zu Verbesserungen folgt nun dem, was Mathematiker eine Asymptote nennen; oder, wirtschaftlich gesehen, unterliegen Verbesserungen einem Gesetz der abnehmenden Renditen, bei dem jeder inkrementelle Gewinn weniger Fortschritt bringt als in der Vergangenheit (Abbildung 4).

Dies ist ein normales Phänomen bei allen physikalischen Systemen. Im Laufe der Geschichte haben Ingenieure in den ersten Jahren der Entwicklung einer Technologie große Fortschritte erzielt, sei es bei Wind- oder Gasturbinen, Dampf- oder Segelschiffen, Verbrennungsmotoren oder Photovoltaikzellen. Mit der Zeit gelingt es den Ingenieuren, an die Grenzen der Natur vorzudringen. Das Prahlen mit dem Recht auf Effizienz- oder Geschwindigkeitssteigerungen oder anderer gleichwertiger Kennzahlen wie Energiedichte (Leistung pro Gewichts- oder Volumeneinheit) schrumpft dann von zweistelligen Prozentsätzen auf Bruchteilsprozente. Ob Solar-, Wind- oder Flugzeugturbinen, die Leistungssteigerungen werden heute alle im einstelligen Prozentbereich gemessen. Ein solcher Fortschritt ist wirtschaftlich sinnvoll, aber nicht revolutionär.

Die physikalisch eingeschränkten Grenzen der Energiesysteme sind eindeutig. Solaranlagen können nicht mehr Photonen umwandeln als diejenigen, die von der Sonne kommen. Windkraftanlagen können nicht mehr Energie gewinnen, als in den kinetischen Strömungen der bewegten Luft vorhanden ist. Die Batterien sind durch die physikalische Chemie der ausgewählten Moleküle gebunden. Ebenso wird eine A380, egal wie viel besser die Triebwerke werden, niemals zum Mond fliegen. Ein ölbefeuerter Motor kann nicht mehr Energie produzieren, als in der physikalischen Chemie der Kohlenwasserstoffe enthalten ist.

Verbrennungsmotoren haben eine so genannte Carnot-Effizienzgrenze, die in der Verbrennungstemperatur und der im Kraftstoff verfügbaren Energie verankert ist. Die Grenzen sind längst festgelegt und gut verstanden. Theoretisch können bei einer ausreichend hohen Temperatur 80% der im Kraftstoff vorhandenen chemischen Energie in Kraft umgewandelt werden. [74] Mit den heutigen Hochtemperaturmaterialien wandeln die besten Kohlenwasserstoffmotoren etwa 50%-60% in Kraft um. Es gibt noch Verbesserungsmöglichkeiten, aber nichts im Vergleich zu den 10- bis fast hundertfachen revolutionären Fortschritte, die in den ersten Jahrzehnten nach ihrer Erfindung erzielt wurden. Wind-/Solartechnologien befinden sich nun an der gleichen Stelle dieser asymptotischen Technologiekurve.

Beim Wind wird die Grenze als Betz-Grenze bezeichnet, die angibt, wie viel von der kinetischen Energie in der Luft ein Flügel aufnehmen kann; diese Grenze liegt bei etwa 60%. [75] Die Erfassung der gesamten kinetischen Energie würde per Definition keine Luftbewegung und damit nichts zu erfassen bedeuten. Es muss Wind geben, damit sich die Turbine drehen kann. Moderne Turbinen übersteigen bereits einen Wirkungsgrad von 45%. [76] Das lässt einige weitere reale Gewinne zu, aber, wie bei Verbrennungsmotoren, nichts Revolutionäres mehr. [77] Eine weitere 10-fache Verbesserung ist nicht möglich.

Bei Silizium-Photovoltaik-(PV)-Zellen wird die physikalische Grenze als Shockley-Queisser-Grenze bezeichnet: Maximal etwa 33% der einfallenden Photonen werden in Elektronen umgewandelt. Modernste kommerzielle PVs erreichen einen Umwandlungswirkungsgrad von etwas über 26%, also nahe der Grenze. Während die Forscher immer wieder neue nicht-siliziumbasierte Optionen entdecken, die verlockende Leistungssteigerungen bieten, haben alle ähnliche physikalische Grenzen, und keine ist auch nur annähernd nahe an der Herstellbarkeit – geschweige denn zu niedrigen Kosten. [78] Es gibt keine 10-fachen Gewinne mehr. [79]

Zukünftige Fortschritte in der Windturbinen- und Solarökonomie konzentrieren sich nun auf inkrementelle technische Verbesserungen: Größenvorteile, indem die Turbinen immer riesiger gebaut werden, höher als das Washington Monument und ähnlich massive, quadratkilometergrosse Solaranlagen im Netzversorgermaßstab. Für beide Technologien sind alle zugrunde liegenden Schlüsselkomponenten – Beton, Stahl und Glasfaser für Wind sowie Silizium, Kupfer und Glas für Solar – bereits in der Massenproduktion und sind auf ihren asymptotischen Kostenkurven schon weit fortgeschritten.

Auch wenn in der Lieferkette mit keinen überraschenden Gewinne bei den Skaleneffekten mehr zu rechnen ist, bedeutet das nicht, dass die Kosten immun gegen Verbesserungen sind. Tatsächlich erfahren alle Herstellungsverfahren bei steigendem Volumina eine kontinuierliche Verbesserung der Produktionseffizienz. Diese Erfahrungskurve wird als Wrights Gesetz bezeichnet. (Dieses „Gesetz“ wurde erstmals 1936 dokumentiert, da es sich damals auf die Herausforderung bezog, Flugzeuge zu Kosten herzustellen, die die Märkte verkraften konnten. Analog dazu, während die Luftfahrt an Fahrt gewann und eine große, weltweite Transportindustrie schuf, wurden Autos und der Bedarf an Schiffen nicht eliminiert.) Erfahrungen, die zu niedrigeren inkrementellen Zusatzkosten führen, sind zu erwarten; aber auch das ist nicht die Art von revolutionärer Verbesserung, die eine neue Energiewirtschaft auch nur annähernd plausibel machen könnte.

Was moderne Batterien betrifft, so gibt es immer noch vielversprechende Möglichkeiten für eine deutliche Verbesserung der zugrunde liegenden physikalischen Chemie. Neue Nicht-Lithium-Materialien in Forschungslabors bieten bis zu 200% und sogar 300% Leistungssteigerung. [80] Solche Gewinne stellen jedoch nicht die Art von 10- oder 100-fachen Fortschritten wie in den Anfängen der Verbrennungschemie dar. [81] Zukünftige Verbesserungen werden die Batterien noch weit weg vom echten Wettbewerb lassen: Erdöl.

Es gibt keine Unterstützung und kein Engineering aus dem Silicon Valley oder anderswo, das die physikalisch-zentrische Lücke in der Energiedichte zwischen Batterien und Öl schließen könnte (Abbildung 5). Die pro Kilogramm gespeicherte Energie ist die entscheidende Messgröße für Fahrzeuge und insbesondere für Flugzeuge. Das maximale Energiepotenzial, das in Ölmolekülen enthalten ist, ist etwa 1.500% größer, Kilogramm um Kilogramm, als das Maximum in der Lithiumchemie. [82] Deshalb werden Flugzeuge und Raketen von Kohlenwasserstoffen angetrieben. Und deshalb ist eine 20%ige Verbesserung des Ölantriebs (durchaus machbar) wertvoller als eine 200%ige Verbesserung der Batterien (immer noch schwierig).

Und schließlich, wenn es um Grenzwerte geht, ist es wichtig zu beachten, dass sich die Technologien, die Schieferöl und -gas freisetzen, noch in den Anfängen der technischen Entwicklung befinden, im Gegensatz zu den älteren Technologien Wind, Solar und Batterien. Zehnfache Gewinne sind noch möglich, wenn es darum geht, wie viel Energie von einer Bohrinsel aus Schiefergestein gewonnen werden kann, bevor sie an physikalische Grenzen stößt. [83] Diese Tatsache erklärt, warum Schieferöl und -gas in den letzten zehn Jahren 2.000 % mehr zur Energieerzeugung in den USA beigetragen haben als Wind und Sonne zusammen. [84]

Digitalisierung wird den Energiesektor nicht Uberisieren

Digitale Werkzeuge verbessern sich bereits und können alle Arten von Effizienzsteigerungen über ganze Wirtschaftsräume hinweg weiter verbessern, und es ist durchaus zu erwarten, dass Software noch erhebliche Verbesserungen sowohl bei der grundlegenden Effizienz von Wind-/Solar-/Batteriemaschinen als auch bei der Effizienz der Integration solcher Maschinen in Infrastrukturen bringen wird. Die Silizium-Logik hat beispielsweise die Steuerung und damit den Kraftstoffverbrauch von Verbrennungsmotoren verbessert, ebenso wie bei Windkraftanlagen. Ebenso hat die von Uber versinnbildlichte Software gezeigt, dass die Optimierung der Effizienz bei der Nutzung teurer Transportmittel die Kosten senkt. Die Nutzung aller Arten von Investitionsgütern ist unvermeidlich.

Die Uberisierung des Stromnetzes ohne Kohlenwasserstoffe ist aber nochmals eine ganz andere Sache.

Das Spitzenbedarfsproblem, das Software nicht lösen kann

In der Energiewelt ist eines der lästigsten Probleme die optimale Abstimmung von Angebot und Nachfrage (Abbildung 6). Hier zeigen die Daten, dass die Gesellschaft und die stromverbrauchende Dienste, die die Menschen mögen, eine wachsende Kluft zwischen Spitzen und Tälern der Nachfrage erzeugen. Der Nettoeffekt für ein kohlenwasserstofffreies Netz wird sein, dass der Bedarf an Batterien zur Deckung dieser Spitzen steigt.

All dies hat Relevanz für die Förderung von EFs. Im Hinblick auf die Bewältigung der ungünstigen zyklischen Natur der Nachfrage wird die Verlagerung des Kraftstoffverbrauchs vom Öl ins Netz das Spitzenmanagement wesentlich schwieriger machen. Die Menschen neigen dazu, zu tanken, wenn es bequem ist; das ist mit Öl leicht zu vollziehen, angesichts der einfachen Lagerung. Die EF-Betankung wird die bereits episodische Natur der Netznachfrage verschärfen.

Um dieses Problem zu lösen, ist ein Vorschlag, die Betankung von Elektrofahrzeugen außerhalb der Spitzenzeiten zu fördern oder sogar zu verlangen. [85] Die Jury ist sich noch nicht darüber im Klaren, wie beliebt das sein wird oder ob es überhaupt toleriert wird.

Obwohl Kilowattstunden und Autos – Schlüssel-Ziele der neuen Vorschriften für die Energiewirtschaft – nur 60% der Energiewirtschaft ausmachen, ist die globale Nachfrage nach beiden noch Jahrhunderte von der Sättigung entfernt. Grüne Enthusiasten machen extravagante Aussagen über die Wirkung von Uber-ähnlichen Optionen und selbstfahrenden Autos. Die Daten zeigen jedoch, dass die wirtschaftlichen Effizienzen von Uberisierung bisher den Einsatz von Autos und die Spitzenbelastungen in der Stadt erhöht haben. [86] Ebenso sehen viele Analysten heute autonome Fahrzeuge, die diesen Effekt verstärken und nicht dämpfen. [87]

Das liegt daran, dass die Menschen und damit die Märkte auf wirtschaftliche Effizienz und nicht auf Energieeffizienz ausgerichtet sind. Erstere kann mit der Reduzierung des Energieverbrauchs in Verbindung gebracht werden, aber sie ist auch und vor allem mit einem erhöhten Energiebedarf verbunden. Autos verbrauchen mehr Energie pro Meile als ein Pferd, aber erstere bieten enorme wirtschaftliche Effizienzgewinne. Auch Computer verbrauchen viel mehr Energie als Bleistift und Papier.

Uberisierung verbessert die Energieeffizienz, erhöht aber die Nachfrage

Jede Energieumwandlung in unserem Universum enthält eingebaute Ineffizienzen – Wärme in Antrieb, Kohlenhydrate in Bewegung, Photonen in Elektronen, Elektronen in Daten und so weiter umzuwandeln. Alles führt zu bestimmten Energiekosten oder Verschwendung, die reduziert, aber nie beseitigt werden können. Doch in der Geschichte zeigt sich nicht ohne Ironie – wie Ökonomen oft festgestellt haben – dass Effizienzsteigerungen zu einem erhöhten, nicht reduzierten Energieverbrauch führen.

Wären erschwingliche Dampfmaschinen zu Beginn der Neuzeit so ineffizient geblieben wie die ersten Erfindungen, dann hätten sie sich nie so ausgebreitet, noch wären die damit verbundenen wirtschaftlichen Gewinne und der damit verbundene Anstieg der Kohlenachfrage eingetreten. Das Gleiche sehen wir bei modernen Verbrennungsmotoren. Heutige Flugzeuge sind zum Beispiel dreimal so energieeffizient wie die ersten Verkehrsflugzeuge in den 1950er Jahren. [88] Das hat den Treibstoffverbrauch nicht reduziert, sondern den Flugverkehr zum Steigen brachte und damit den Treibstoffverbrauch um das Vierfache erhöht. [89]

Ebenso waren es die erstaunlichen Fortschritte bei der Energieeffizienz der Computer, die den rasanten Anstieg des Datenverkehrs im Internet verursachten – was zu einem deutlich höheren Energieverbrauch der Computer führte. Globale Datenverarbeitung und Kommunikation verbraucht heute das Energieäquivalent von 3 Milliarden Barrel Öl pro Jahr, mehr Energie als die globale Luftfahrt. [90]

Der Zweck der Effizienzsteigerung in der realen Welt im Gegensatz zur politischen Welt besteht darin, die Kosten für die Nutzung der Vorteile eines energieverbrauchenden Motors oder einer energieverbrauchenden Maschine zu senken. Solange Menschen und Unternehmen mehr von den Vorteilen wollen, führen sinkende Kosten zu einer erhöhten Nachfrage, die im Durchschnitt alle „Einsparungen“ aus den Effizienzgewinnen übertrifft. Abbildung 7 zeigt, wie sich dieser Effizienzeffekt bei Computerisierung und dem Flugverkehr ausgewirkt hat. [91]

Natürlich kann die Steigerung des Nachfragewachstums nach einem bestimmten Produkt oder einer bestimmten Dienstleistung in einer (wohlhabenden) Gesellschaft nachlassen, wenn die Grenzen erreicht sind: die Menge an Lebensmitteln, die eine Person essen kann, die Meilen pro Tag, die eine Person bereit ist zu fahren, die Anzahl an Kühlschränken oder Glühbirnen pro Haushalt, etc. Aber eine Welt mit 8 Milliarden Menschen ist noch lange nicht an solche Grenzen gestoßen.

Das Gesamtbild des Zusammenhangs zwischen Effizienz und Weltenergiebedarf ist eindeutig (Abbildung 8). Die Technologie hat die Energieeffizienz der Gesellschaft kontinuierlich verbessert. Aber weit davon entfernt, das globale Energiewachstum zu beenden, hat die Effizienz es erst ermöglicht. Die durch die digitalen Technologien erzielten Kosten- und Effizienzverbesserungen werden diesen Trend beschleunigen und nicht beenden.

Energie-Revolutionen liegen immer noch jenseits des Horizonts

Wenn die ärmsten 4 Milliarden Menschen der Welt ihren Energieverbrauch auf nur 15% des Pro-Kopf-Niveaus der entwickelten Volkswirtschaften erhöhen, wird der globale Energieverbrauch um das Äquivalent dessen steigen, als würde der Wert um die Nachfrage der gesamten USA erhöht. [92] Angesichts solcher Prognosen gibt es Vorschläge, dass Regierungen die Nachfrage einschränken und sogar bestimmte energieverbrauchende Verhaltensweisen verbieten sollten. Ein akademischer Artikel schlug vor, dass der „Verkauf von energiehungrigen Versionen eines Geräts oder einer Anwendung auf dem Markt verboten werden könnte, und die Beschränkungen könnten von Jahr zu Jahr allmählich strenger werden, um energiesparende Produktlinien zu stimulieren.“ [93] Andere haben Vorschläge unterbreitet, die „Abhängigkeit von Energie“ zu verringern, indem sie die Größe der Infrastrukturen einschränken oder die Nutzung von öffentlichen Verkehrsmitteln oder Fahrgemeinschaften vorschreiben. [94]

Dabei geht es nicht nur darum, dass ärmere Menschen unweigerlich mehr wie wohlhabendere Menschen leben wollen und können, sondern auch darum, dass neue Erfindungen immer wieder neue Energiebedürfnisse schaffen. Die Erfindung des Flugzeugs bedeutet, dass jede 1 Milliarde Dollar in neu produzierten Jets zu einem Treibstoffverbrauch von rund 5 Milliarden Dollar führt, der in zwei Jahrzehnten für deren Betrieb aufgewendet wird. Ebenso verbraucht jede 1 Milliarde in Rechenzentren investierte Dollar im gleichen Zeitraum 7 Milliarden Dollar an Stromverbrauch. [95] Die Welt kauft beides zum Preis von etwa 100 Milliarden Dollar pro Jahr. [96]

Der unaufhaltsame Marsch des technologischen Fortschritts für Dinge, die Energie verbrauchen, schafft die verführerische Idee, dass etwas radikal Neues auch bei der Energiegewinnung unvermeidlich ist. Aber manchmal ist die alte oder etablierte Technologie die optimale Lösung und nahezu immun gegen Störungen. Wir verwenden immer noch Stein, Ziegel und Beton, die alle aus der Antike stammen. Wir tun dies, weil sie optimal sind, nicht „alt“. Ebenso wie das Rad, die Wasserleitungen, die elektrischen Leitungen… die Liste ist lang. Kohlenwasserstoffe sind bisher der optimale Weg, um das meiste von dem, was die Gesellschaft braucht und will, mit Energie zu versorgen.

Vor mehr als einem Jahrzehnt konzentrierte Google sein geschätztes Ingenieurstalent auf ein Projekt namens „RE<C“, das darauf abzielte, erneuerbare Energien zu entwickeln, die kostengünstiger sind als Kohle. Nachdem das Projekt 2014 abgesagt wurde, schrieben die leitenden Ingenieure von Google: „Inkrementelle Verbesserungen an bestehenden [Energie-] Technologien reichen nicht aus; wir brauchen etwas wirklich disruptives… Wir haben keine Antworten.“ [97] Diese Ingenieure haben die in diesem Beitrag hervorgehobenen Realitäten der Physik und Skalierung wiederentdeckt.

Eine Energierevolution wird nur durch das Streben nach grundlegenden Wissenschaften entstehen. Oder, wie Bill Gates es formuliert hat, die Herausforderung verlangt nach wissenschaftlichen „Wundern“. [98] Diese werden aus der Grundlagenforschung und nicht aus der Förderung der Technologien von gestern hervorgehen. Das Internet entstand nicht durch die Subventionierung des Wählscheibentelefons, noch der Transistor durch die Subventionierung von Vakuumröhren oder das Automobil durch die Subventionierung von Eisenbahnen.

Allerdings sind 95 % der FuE-Ausgaben des privaten Sektors und der Großteil der staatlichen FuE auf „Entwicklung“ und nicht auf die Grundlagenforschung ausgerichtet. [99] Wenn die Politik eine Revolution in der Energietechnik anstrebt, wäre die wichtigste Einzelmaßnahme eine radikale Neuausrichtung und Ausweitung der Unterstützung der wissenschaftlichen Grundlagenforschung.

Kohlenwasserstoffe – Öl, Erdgas und Kohle – sind heute und in absehbarer Zeit die wichtigste Energiequelle der Welt. Windkraftanlagen, Solaranlagen und Batterien stellen dagegen eine kleine Energiequelle dar, und die Physik diktiert, dass sie dies auch bleiben. Inzwischen gibt es einfach keine Möglichkeit, dass die Welt einen kurzfristigen Übergang zu einer „neuen Energiewirtschaft“ vollzieht oder vollziehen kann.

Kommentare

Die „Neue Energiewirtschaft“: Eine Übung in magischem Denken — Keine Kommentare

HTML tags allowed in your comment: <a href="" title=""> <abbr title=""> <acronym title=""> <b> <blockquote cite=""> <cite> <code> <del datetime=""> <em> <i> <q cite=""> <s> <strike> <strong>